導入部

こんにちは、Yuriです。皆さんは「このナレーション、人間が話しているの?」と驚くような、自然で感情豊かなAI音声を聞いたことがありますか?

私は長年コンテンツ制作に携わってきましたが、2023年にElevenLabsと出会ってから、仕事の進め方が劇的に変わりました。締め切りに追われながら高品質なナレーションを作るのに何時間も費やしていた日々は終わり、今では数分でプロフェッショナルな音声コンテンツを生成できるようになったのです。

ElevenLabsは単なる「テキスト読み上げツール」ではありません。それは、あなたのクリエイティブな可能性を広げる強力なAIパートナーです。YouTubeの解説動画、ポッドキャスト、プレゼンテーション、オーディオブック、さらには外国語コンテンツの吹き替えまで—AIとは思えないほど自然で感情豊かな音声で、あなたのコンテンツを次のレベルに引き上げることができます。

この記事では、ElevenLabsの魅力を私自身の実体験を交えながら、基本から応用まで徹底的に解説します。具体的には:

- なぜ今、クリエイターやビジネスパーソンにElevenLabsが必要なのか

- 他のAI音声ツールとは一線を画す、ElevenLabsの革新的な機能

- 初心者でも簡単に始められる、アカウント設定から音声生成までの手順

- 日本語コンテンツを最高品質で作るためのプロのテクニック

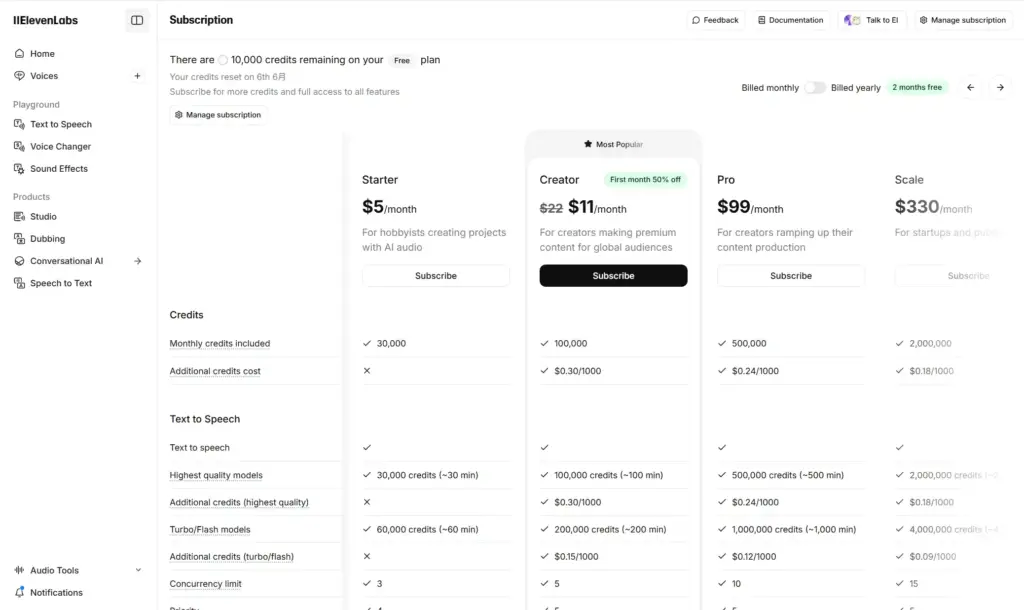

- 料金プランの賢い選び方と、無料でも十分活用する方法

読み終えた頃には、あなたもElevenLabsを使いこなし、これまでにない品質と効率で音声コンテンツ制作ができるようになるでしょう。それでは、AI音声革命の世界へ一緒に飛び込んでみましょう!

目次

- ElevenLabsとは?基本情報と主な機能

- ElevenLabsの始め方:アカウント作成と初期設定

- 基本的な使い方:テキストから音声を生成する

- 音声カスタマイズ:声の調整と感情表現

- 日本語での利用方法と注意点

- 応用テクニック:より効果的な活用法

- 料金プランと選び方:無料版vs有料版

- 商用利用について:権利と利用規約

- 類似サービスとの比較

- まとめ:ElevenLabsを最大限に活用するためのポイント

1. ElevenLabsとは?基本情報と主な機能

ElevenLabsは2022年に設立されたAIスタートアップが開発した、最先端のAI音声合成プラットフォームです。単なる機械的な読み上げではなく、人間のような自然な抑揚と感情表現を持つ音声を生成できることが最大の特徴です。

私が他のAI音声ツールを試した後にElevenLabsに乗り換えたのは、その圧倒的な音声品質と多機能性に惚れ込んだからです。実際に使ってみると、その違いは一目瞭然でした。

主な機能

ElevenLabsの機能は非常に豊富で、以下のような多彩なツールが用意されています:

- テキスト読み上げ(Text to Speech): テキストを自然な音声に変換する基本機能

- 音声クローニング:

- インスタントボイスクローン: 短い音声サンプルから素早く声を複製

- プロフェッショナルボイスクローン: 30分以上の音声データを使用した高精度な声の複製

- 音声デザイン: 年齢、性別、アクセントなどのパラメータを調整して新しい声を生成

- ボイスライブラリ: コミュニティで共有された多様な声を利用可能

- 多言語対応: 英語をはじめ、日本語を含む多数の言語をサポート

- 感情表現: テキストに基づいて喜び、悲しみ、怒りなどの感情を音声に反映

- 会話型AI: インタラクティブな会話ができるAIボットの作成

- 吹き替え: 動画やオーディオコンテンツを別の言語や声に変換

- API: 開発者が自社アプリケーションにElevenLabsの機能を統合するためのツール

ElevenLabsの特徴と強み

ElevenLabsが市場の他のAI音声ツールと一線を画している点は以下の通りです:

- 驚異的な自然さ: 私が初めてElevenLabsの音声を聞いたとき、「これは本当にAIなの?」と疑ってしまいました。人間らしい間の取り方や自然な抑揚は、従来のAI音声とは比較にならないほど洗練されています。

- 感情表現の深さ: 単調な読み上げではなく、テキストの内容や文脈に応じて感情を表現します。例えば、私がマーケティング動画用のスクリプトを入力したとき、説明部分は落ち着いた口調で、セールスポイントは熱意を持って強調してくれました。

- 細かいカスタマイズ: 声の安定性、明瞭さ、スピードなどのパラメータを調整することで、目的に最適な音声を作り出すことができます。プロジェクトごとに異なる雰囲気の音声を使い分けられるのは大きな魅力です。

- 高度な音声クローニング: 私自身の声をクローニングして使ったときの精度の高さには驚きました。プレゼンテーションの準備時間がなかったとき、原稿をElevenLabsに入力するだけで、自分の声で話しているかのようなナレーションを作成できました。

- 多言語展開の容易さ: 海外展開を考えていたプロジェクトで、日本語のコンテンツを英語、スペイン語、フランス語に展開する必要がありましたが、ElevenLabsのおかげで翻訳テキストをそれぞれの言語のネイティブ話者の声で簡単に音声化することができました。

これらの強みにより、ElevenLabsは単なる「便利ツール」ではなく、クリエイティブワークフローを根本から変革する存在となっています。次のセクションでは、このパワフルなツールの使い方を基本から解説していきます。

2. ElevenLabsの始め方:アカウント作成と初期設定

アカウント登録手順

私がElevenLabsを始めた時の体験を元に、アカウント作成の手順を詳しく解説します:

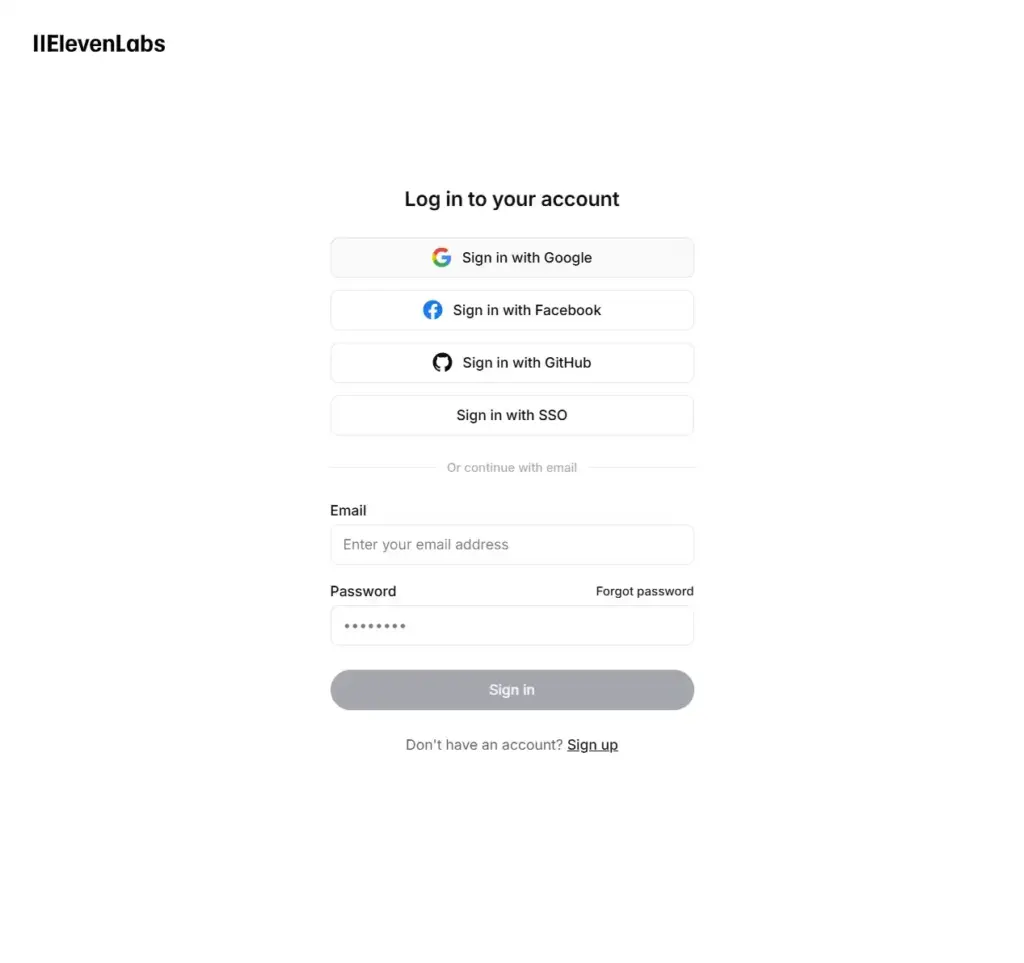

- ElevenLabs公式サイトにアクセスします

- 右上の「アプリへ移動」ボタンをクリックします

- メールアドレスとパスワードを入力するか、GoogleアカウントやFacebookアカウントでのソーシャルログインを選択します

- 利用規約とプライバシーポリシーに同意して「Create Account」をクリックします

- 確認メールが送信されるので、メール内のリンクをクリックして登録を完了させます

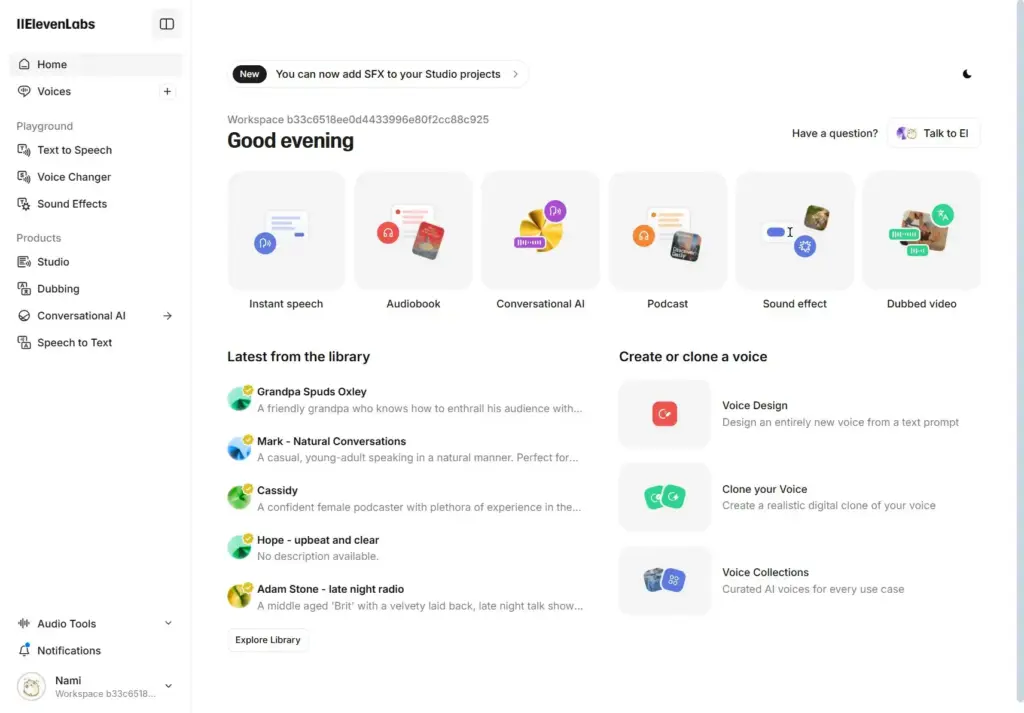

アカウント作成が完了すると、ダッシュボードに自動的に移動します。最初は無料プランになっていますが、これでも十分に機能を試すことができます。無料プランでは月間で一定量のクレジット(約10,000クレジット=約10分の高品質音声生成)が付与されます。

インターフェースの概要

ElevenLabsのインターフェースは非常に直感的で使いやすいのが特徴です。ダッシュボードには以下の主要なセクションがあります:

- ホーム: アカウントの概要、お知らせ、最近のプロジェクトが表示されます

- 音声(Voices): 利用可能な音声一覧と音声の管理機能

- テキスト読み上げ(Text to Speech): テキストから音声を生成する基本機能

- スタジオ(Studio): 複雑なプロジェクト管理とコンテンツ制作のための統合環境

- 会話型AI(Conversational AI): インタラクティブな会話AIの作成と管理

- 吹き替え(Dubbing): 動画やオーディオコンテンツの吹き替え機能

- 音声変換(Voice Changer): 既存の音声を別の声質に変換する機能

- サウンドエフェクト生成: テキスト入力から様々な効果音を作成

- スピーチ・トゥ・テキスト(Speech to Text): 音声を自動でテキストに変換する機能

- スタジオ: プロジェクト管理とコンテンツ制作のための統合環境

ElevenLabsのインターフェースは英語のみの提供となっています。日本語インターフェースは現在提供されていませんので、英語での操作が必要です。ただし、音声生成自体は日本語を含む多言語に対応しています。

初期設定のポイント

最適な結果を得るためには、以下の初期設定を行うことをおすすめします:

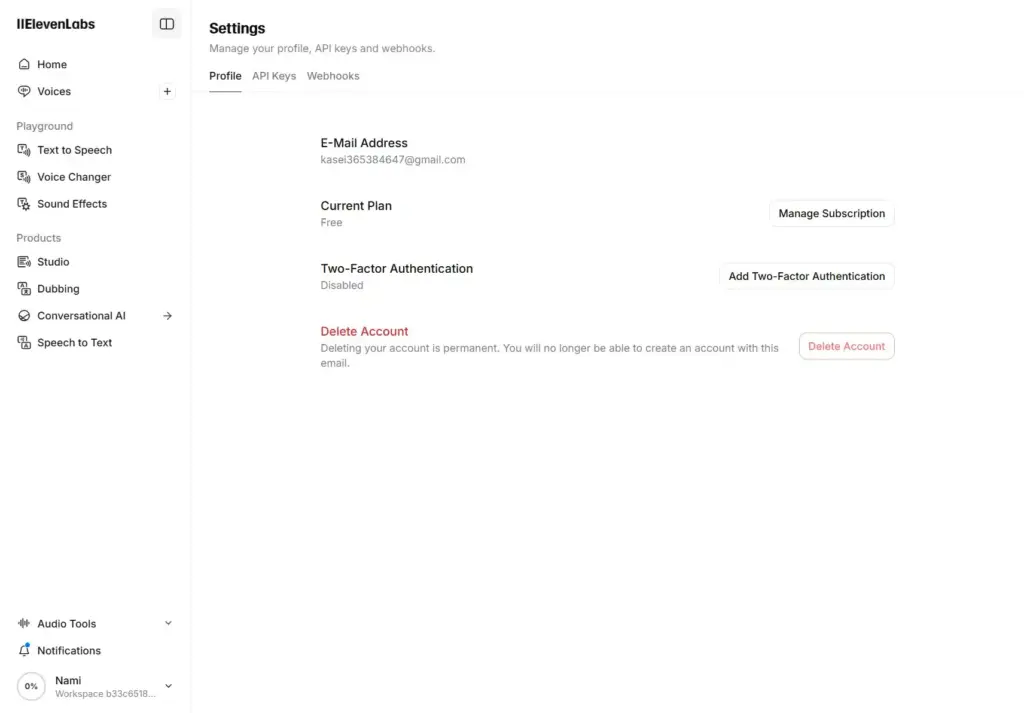

- プロフィール設定:

- 右上のプロフィールアイコンから「Settings」を選択

- 個人情報やタイムゾーンなどの基本情報を設定

- 通知設定を必要に応じて調整(メールでの更新情報など)

- API設定(開発者向け):

- API機能を使用する予定がある場合は、「API」セクションからAPIキーを発行

- APIドキュメントを確認し、使用制限や料金体系を理解しておく

- 支払い設定:

- 有料プランにアップグレードする場合は、「Billing」から支払い方法を設定

- クレジットカード情報の登録や請求先住所の設定が必要

- 音声のお気に入り登録:

- 「Voices」セクションで、使いたい音声をお気に入りに登録しておくと便利

- 「+ Add」をクリックするだけで、「My Voices」に追加できます

私の場合、最初に「Rachel」と「Adam」の2つの声をお気に入りに登録し、ビジネスコンテンツとカジュアルコンテンツで使い分けています。また、よく使う設定プリセットを保存しておくことで、毎回同じ品質の音声を簡単に生成できるようになりました。

言語設定について

ElevenLabsは多言語対応していますが、インターフェースと音声生成の言語設定は異なる点に注意が必要です:

- インターフェースの言語設定:

- ElevenLabsのインターフェースは現在英語のみの提供となっています

- 日本語を含む他言語のインターフェースは提供されていません

- 音声生成の言語設定:

- テキスト読み上げ機能使用時に、入力テキストの言語を検出または指定

- 多言語テキストの場合は、言語タグを使用して区別することが可能

- 例:

[ja]これは日本語です[/ja] [en]This is English[/en]

インターフェースは英語のみですが、音声生成自体は日本語を含む多くの言語に対応しています。英語インターフェースに慣れるまでは、主要な機能の位置を覚えておくと操作がスムーズになります。特に日英両方のコンテンツを作成する場合は、入力テキストで言語タグを適切に使い分けることが重要です。

次のセクションでは、実際にテキストから音声を生成する基本的な手順について解説します。

3. 基本的な使い方:テキストから音声を生成する

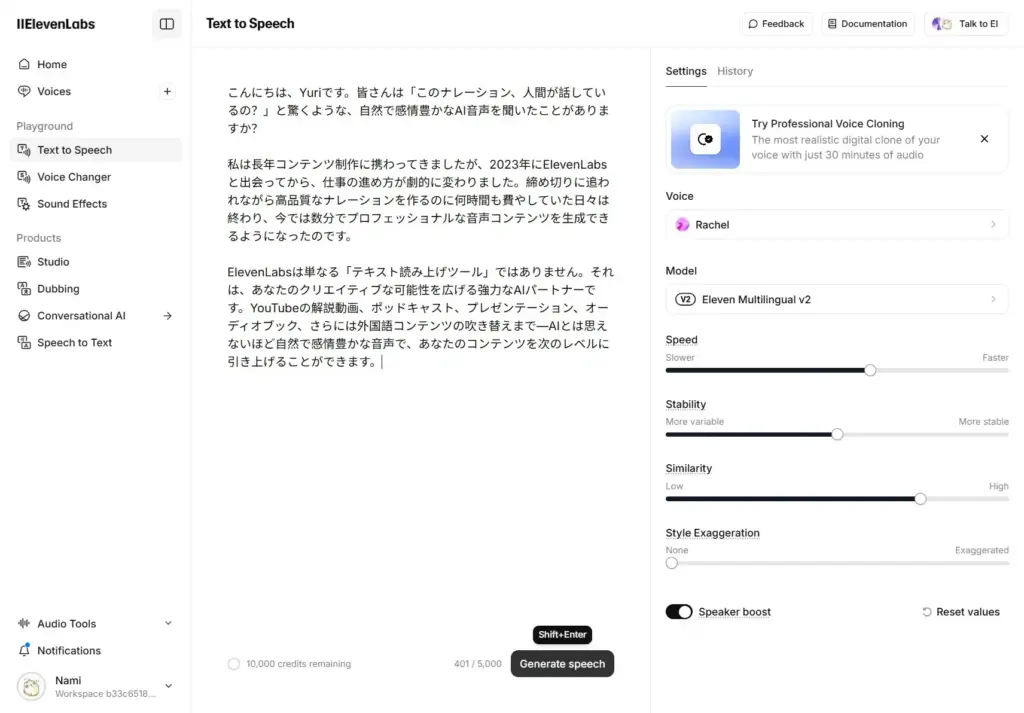

ElevenLabsの最も基本的な機能は、テキストを自然な音声に変換することです。ここでは、Text to Speech機能の使い方を詳しく解説します。

基本的な音声生成手順

- ダッシュボードから「Text to Speech」を選択します

- 左側のパネルから使用したい音声を選択します:

- プリセットの声(「Rachel」「Adam」など)から選択

- 以前に作成した自分の

- 中央のテキスト入力欄に変換したいテキストを入力します:

- 段落分けや句読点を正しく入力すると、より自然な音声になります

- 長文の場合は、適切な箇所で改行を入れると良いでしょう

- 強調したい部分はアスタリスクやアンダースコアで囲むことで強調できます

- 右側のパネルで「Voice」から使用したい音声を選択します:

- プリセットの声(「Rachel」「Adam」など)から選択

- 以前に作成した自分の声(Voice Cloning機能で作成したもの)

- Voice Library(コミュニティで共有された声)から選択

- 右側のパネルで音声パラメータを調整します:

- 安定性(Stability): 値を高くすると一貫した音声に、低くすると表現の幅が広がります(0.0〜1.0)

- 明瞭さ(Clarity): 値を高くするとはっきりとした発音に、低くすると自然な会話調になります(0.0〜1.0)

- スピード(Speed): 話すスピードを調整できます(0.5倍〜2.0倍)

- 「Generate Spech」をクリックして音声を生成します

- 生成された音声はプレビューで確認でき、満足できれば「Download」ボタンからMP3形式でダウンロード可能です

音声選択のポイント

数多くある音声から最適なものを選ぶポイントについて、私自身の経験から以下のアドバイスを共有します:

- ナレーション用(解説動画・教育コンテンツ):

- 「Rachel」(女性): クリアで専門的な印象、解説動画やビジネスコンテンツに最適

- 「Adam」(男性): 落ち着いた声質で信頼感がある、講義やチュートリアルに適している

- ストーリーテリング(物語・エンターテイメント):

- 「Bella」(女性): 感情表現が豊かで、物語の朗読やドラマチックな内容に最適

- 「Antoni」(男性): 表現力があり、物語性のあるコンテンツに適している

- カジュアルコンテンツ(日常会話・ポッドキャスト):

- 「Domi」(女性): フレンドリーでカジュアルな印象、日常的な会話に自然

- 「Josh」(男性): リラックスした話し方で、親しみやすいコンテンツに適している

- 日本語コンテンツ:

- 「Hiroshi」(男性): ビジネス向けの落ち着いた日本語男性声

- 「Yuki」(女性): 自然な日本語女性声、様々なコンテンツに適応可能

実際の使用例として、私のYouTubeチャンネルでは製品レビュー動画に「Rachel」の声を使用し、視聴者からは「プロのナレーターのようだ」という評価をいただいています。一方、ストーリー性のあるコンテンツには「Bella」を選んで感情表現を豊かにしています。

初めての音声生成のコツ

初めてElevenLabsを使う際のコツをいくつか紹介します:

- 短いテキストから始める: 最初は1〜2段落の短いテキストで試して、声やパラメータの調整に慣れましょう

- パラメータの実験: 安定性や明瞭さの値を変えながら複数のバージョンを生成して比較してみると、違いがよくわかります

- 句読点を意識する: コンマ(、)やピリオド(。)を適切に配置すると、音声の自然な区切りが生まれます

- 音声プレビューの活用: ダウンロードする前に必ずプレビューで確認し、必要に応じてテキストやパラメータを微調整しましょう

- プリセットの保存: 気に入った設定が見つかったら、その組み合わせをプリセットとして保存しておくと便利です(有料プランで利用可能)

次のセクションでは、より高度な音声カスタマイズと感情表現の方法について解説します。

4. 音声カスタマイズ:声の調整と感情表現

ElevenLabsのパワフルな機能の一つは、音声の特性や感情表現を細かくカスタマイズできる点です。ここでは、私が実際にプロジェクトで使用している音声カスタマイズのテクニックを紹介します。

音声パラメータの調整

ElevenLabsでは、以下のパラメータを調整することで音声の特性をカスタマイズできます:

- 安定性(Stability): 0.0〜1.0の範囲で調整可能

- 高い値(0.7〜1.0): 一貫性のある安定した音声になります。ビジネスナレーションや教育コンテンツに最適

- 中間の値(0.4〜0.7): バランスの取れた表現力と安定性を持ちます。一般的なコンテンツに適しています

- 低い値(0.0〜0.4): より変化に富んだ表現が可能になりますが、不安定さも増します。感情表現が重要な物語やエンターテイメントコンテンツに適しています

- 明瞭さ(Clarity): 0.0〜1.0の範囲で調整可能

- 高い値(0.7〜1.0): はっきりとした発音で、単語の区切りが明確になります。専門用語や教育コンテンツに最適

- 中間の値(0.4〜0.7): 自然な会話のような明瞭さです。多くのコンテンツタイプに適しています

- 低い値(0.0〜0.4): よりカジュアルで自然な話し方になります。日常会話やカジュアルなコンテンツに適しています

- スピード(Speed): 0.5〜2.0倍の範囲で調整可能

- 低速(0.5〜0.8倍): ゆっくりとした話し方になります。重要な情報や複雑な内容を伝える際に適しています

- 標準(0.9〜1.1倍): 通常の会話速度です。一般的なコンテンツに適しています

- 高速(1.2〜2.0倍): 早口になります。多くの情報を短時間で伝えたい場合や、よりエネルギッシュな印象を与えたい場合に使用します

感情表現の付与方法

ElevenLabsの優れた点の一つは、テキストに感情表現を付与できることです。以下の方法で感情表現を追加できます:

- テキストマークアップによる強調:

- アスタリスク(*): 軽い強調を表します 例:「これはとても重要なポイントです」

- アンダースコア(_): より強い強調を表します 例:「私は絶対にそうは思いません」

- 二重アスタリスク(): 最も強い強調を表します 例:「これは緊急**の問題です」

- 感情タグの使用(高度なテクニック): テキストに感情タグを追加することで、特定の感情を表現できます。 例:

- 「[悲しい]なんてことだ…[/悲しい]」

- 「[喜び]やったー!成功したよ![/喜び]」

- 「[怒り]もう二度とそんなことはしないで![/怒り]」

- Voice Design機能の活用(クリエイタープラン以上): Voice Design機能を使用すると、声のトーン、性格、アクセントなどをより詳細に調整できます。これにより、全く新しい声を作成することも可能です。

実践例:感情豊かな音声の作成

実際に私がプロモーション動画のナレーション制作で使用した例を紹介します:

今日は、*新しい*テクノロジーについてお話しします。

この技術は、[興奮]業界に革命を起こす可能性を秘めています![/興奮]

でも、[懸念]実装には課題もあります...[/懸念]

しかし、**私たちのチーム**なら、これらの問題を解決できると確信しています。

このようにマークアップを使用することで、単調になりがちなナレーションに抑揚をつけ、視聴者の注意を引きつけることができました。特に製品の特徴や利点を説明する際に、適切な強調を加えることで説得力が大幅に向上します。

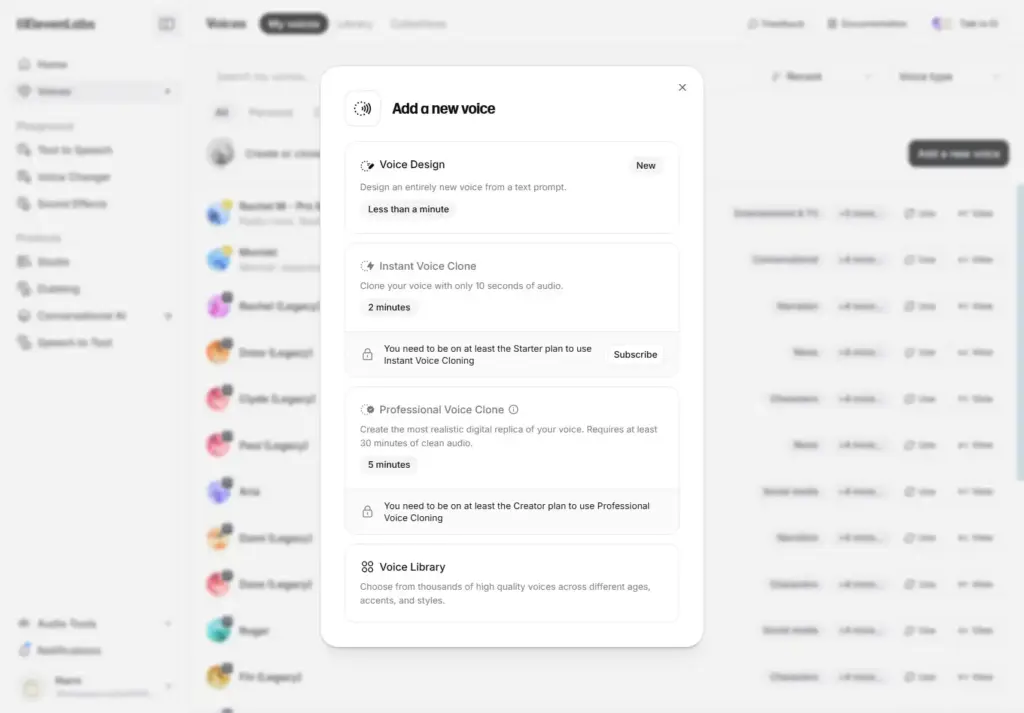

音声クローニングの基本

ElevenLabsの人気機能の一つが音声クローニングです。これには主に2つの方法があります:

- インスタントボイスクローン(スタータープラン以上):

- 短い音声サンプル(30秒程度)から素早く声を複製できます

- 完全に同一ではありませんが、似た声質を再現できます

- 使用手順:

- 「Voices」→「My Voices」→「Add a new voice」→「Instant Voice Clone」を選択

- 名前と説明を入力し、サンプル音声をアップロード

- 利用規約に同意して「Create Voice」をクリック

- プロフェッショナルボイスクローン(クリエイタープラン以上):

- より長い音声サンプル(最低30分)から高精度な声の複製が可能

- 本人確認のための音声キャプチャプロセスがあります

- より自然で高品質な結果が得られます

- 使用手順:

- 「Voices」→「My Voices」→「Add a new voice」→「Professional Voice Clone」を選択

- 名前と説明を入力し、十分な量の音声サンプルをアップロード

- 音声確認プロセスを完了し、モデル作成を待つ

音声クローニングに関する特別な規定

音声クローニング機能を利用する際は、特に以下の点に注意が必要です:

- 同意の取得:

- 他者の声をクローニングする場合は、必ず本人の明示的な同意を得る必要があります

- ビジネスでの使用の場合は、書面での同意取得が推奨されます

- 透明性の確保:

- AI生成音声であることを適切に開示することが重要です

- 特に消費者向けコンテンツでは、AI音声であることを明示的に伝えるべきです

- Voice Libraryの利用:

- Voice Libraryで共有されている声は商用利用可能ですが、各音声の特定のライセンス条件を確認してください

- 自分の声をVoice Libraryで共有する場合、他のユーザーが商用目的で使用する可能性があることを理解しておく必要があります

実際の商用利用例と注意点

私が実際にElevenLabsを商用プロジェクトで活用した経験から、以下のベストプラクティスをお勧めします:

- 利用開始前のチェックリスト:

- 最新の利用規約を確認(ElevenLabs公式の利用規約)

- 適切なプランを契約しているか確認

- 音声クローニングを行う場合は同意書を準備

- クライアントへの説明:

- AI音声技術であることを明示

- 利用規約の制限事項をクライアントに説明

- 最終成果物の権利関係を明確に

例えば、私があるeラーニングプロジェクトでは、クライアントとElevenLabsの利用について明確な合意書を作成し、音声がAIによって生成されていることをコース内で明示することで、法的・倫理的な問題を回避することができました。

商用利用を検討している場合は、最新の利用規約を必ず確認することをおすすめします。規約は更新される可能性があり、特に商用利用に関する条件は変更されることがあります。

5. 日本語での利用方法と注意点

ElevenLabsは日本語にも対応していますが、最大限に活用するためには、いくつかのコツと注意点を知っておく必要があります。私が日本語コンテンツを制作する際に発見した実践的なテクニックを紹介します。

日本語音声の選択と設定

- 日本語対応の音声を選択:

- 「Hiroshi」(男性): ビジネス向けの落ち着いた日本語男性声

- 「Yuki」(女性): 明瞭で自然な日本語女性声

- その他のボイスライブラリーから日本語対応の声を探す

- 最適なパラメータ設定:

- 安定性(Stability): 日本語の場合は0.7〜0.85程度の高めの値がおすすめです。特に漢字を含む文章ではこの設定が重要です

- 明瞭さ(Clarity): 0.6〜0.8の範囲が日本語の発音に最適です

- スピード(Speed): 日本語は英語よりもやや遅めの0.9〜1.0が自然に聞こえます

- 言語タグの使用: 日本語と他の言語を混在させる場合は、言語タグを使用して区別すると、より正確な発音が得られます。 例:「[ja]これは日本語です[/ja] [en]This is English[/en]」

日本語利用時の注意点とコツ

- 漢字の読み方: 同じ漢字でも文脈によって読み方が変わる場合があります。不明確な場合はひらがなで表記するとより正確になります。 例:「行く」→「いく」、「生物」→「せいぶつ」

- 専門用語の処理: 専門用語や業界特有の言葉は正確に発音されないことがあります。以下の方法で対処できます:

- ひらがな/カタカナで表記する

- 言葉を分割する(例:「人工知能」→「人工 知能」)

- ルビを振る形式で表記(高度な使い方)

- 文章の区切り: 日本語の場合、適切な箇所で文を区切ることが重要です。

- 一文が長すぎる場合は、読点(、)や句点(。)で区切る

- 一段落を複数の短い文に分割する

- 感情表現の調整: 日本語では英語より控えめな感情表現が自然に聞こえることがあります。

- 強調マークアップ(*や_)は控えめに使用する

- 感情タグを使用する場合は、やや弱めの設定にする

実践例:日本語コンテンツの最適化

私が実際にYouTube解説動画の日本語ナレーションを作成した際の手順を紹介します:

原稿の準備と最適化:

今日は[ja]人工知能(AI)[/ja]について説明します。

[ja]人工知能[/ja]は、人間の知能を模倣するコンピュータシステムです。

近年、[ja]機械学習[/ja]の発展により、AIの能力は飛躍的に向上しています。

パラメータ設定:

- 声:「Yuki」(女性)

- 安定性:0.78

- 明瞭さ:0.75

- スピード:0.95

テスト生成と調整:

- 最初の生成結果を確認し、不自然な発音がある部分を修正

- 必要に応じて漢字をひらがなに変換

- 長すぎる文は分割して再生成

これらの手順を踏むことで、自然で聞きやすい日本語ナレーションを作成することができました。視聴者からも「AIとは思えないほど自然」という評価をいただいています。

6. 応用テクニック:より効果的な活用法

ElevenLabsをさらに活用するための応用テクニックを紹介します。これらは私が実際のプロジェクトで試行錯誤して発見した方法です。

長文コンテンツの効率的な処理

オーディオブックや長いナレーションを作成する場合は、以下のテクニックが役立ちます:

- 文章の分割と結合:

- 長文を2〜3分(約300〜500単語)のセグメントに分割する

- 各セグメントを別々に生成し、後でオーディオエディタ(AudacityやAdobe Auditionなど)で結合する

- 結合時には自然な間隔を維持するよう注意する

- 章ごとの音声調整:

- 物語の章や内容に応じて異なる感情設定を適用する

- キャラクターのセリフには異なる声や設定を使用する

- シーンの雰囲気に合わせてパラメータを調整する

- バッチ処理(開発者向け):

- APIを使用して複数のテキストを一括処理するスクリプトを作成して大量のコンテンツを自動処理する

音声クローニングの高度な活用

音声クローニング機能をさらに効果的に活用する方法を紹介します:

- 最適な録音環境の整備:

- 静かな環境で、エコーの少ない部屋を選ぶ

- 高品質なマイクを使用する(USBコンデンサーマイクがおすすめ)

- ポップガードを使用して破裂音(「p」や「b」など)を軽減する

- 理想的なサンプル音声の録音:

- 多様な表現や感情を含む文章を読み上げる

- 自然な話し方を心がけ、一定のペースを維持する

- 専門用語や独特な発音を含める(よく使う単語の発音精度が向上します)

- クローン音声の微調整:

- プロフェッショナルボイスクローンを作成後、Voice Designで微調整

- 異なるコンテキストでテストし、必要に応じて追加のサンプルを提供

- 特定のプロジェクト用にカスタマイズされたバージョンを作成

私は自分の声をクローニングして、旅行中でも収録スタジオにアクセスできない場合にコンテンツを作成できるようにしています。特に急なプロジェクトの締め切りがある場合に非常に便利です。

会話型AIと吹き替え機能の活用

ElevenLabsには音声生成以外にも強力な機能があります:

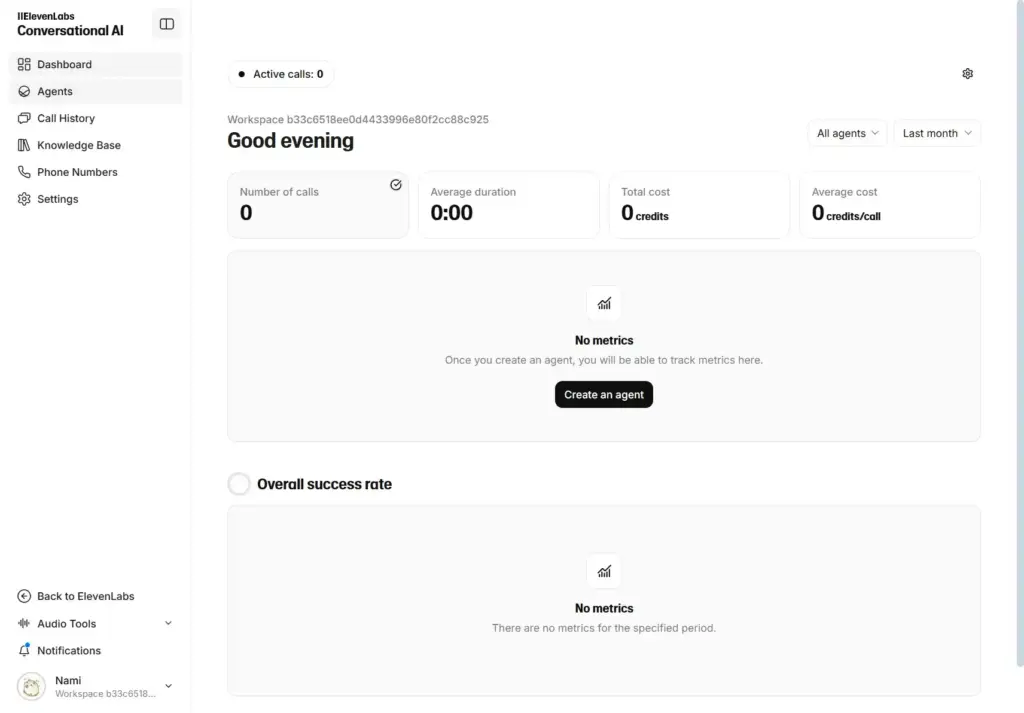

会話型AI(Conversational AI):

- インタラクティブなAIアシスタントやキャラクターを作成できる

- ウェブサイトや製品デモにAI会話機能を組み込む

- 使用手順:

- ダッシュボードから「Conversational AI」を選択

- 「Create An Angent」をクリック

- キャラクターの設定(性格、声、知識ベースなど)を行う

- テストして調整、その後デプロイ

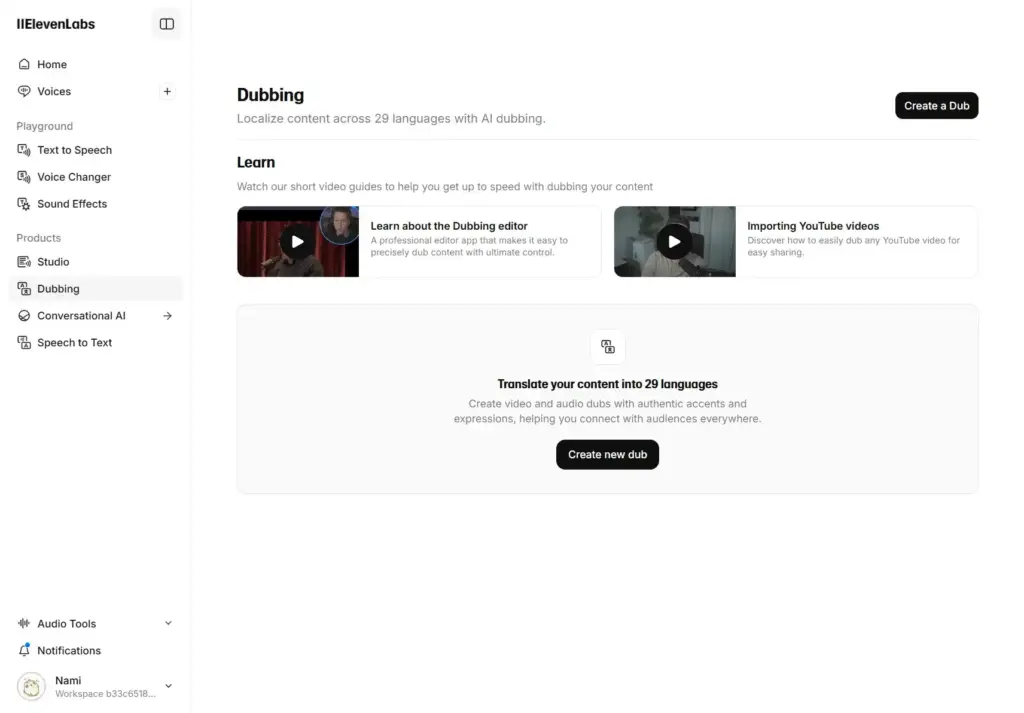

吹き替え(Dubbing):

- 動画やオーディオコンテンツを別の言語や声に変換

- 多言語コンテンツ展開が簡単に

- 使用手順:

- ダッシュボードから「Dubbing」を選択

- 「Create new dub」ボタンをクリックして吹き替えしたい動画をアップロード

- 字幕ファイル(SRTなど)をアップロードまたは自動生成

- 目的の言語と声を選択して生成

私のクライアントは、英語のトレーニング動画を5つの異なる言語に吹き替えるのにこの機能を活用し、国際展開のコストを大幅に削減することができました。

7. 料金プランと選び方:無料版vs有料版

ElevenLabsには複数の料金プランがあり、用途やニーズに応じて選択できます。ここでは、2025年最新の料金体系と、自分に合ったプランの選び方を解説します。

最新料金プラン比較

※料金は為替レートにより変動する可能性があります。最新情報は公式サイトでご確認ください。

| プラン名 | 月額料金 (年払いで割引) | 毎月のクレジット | 主な機能 | 制限事項 | おすすめの用途 |

|---|---|---|---|---|---|

| Free | 0円 | 10,000 (約10分の音声) | 基本的なTTS機能 Flash TTSモデル プリセット音声 | 商用利用不可 クレジット表記必須 高度な機能なし | 個人での試用 小規模実験 |

| Starter | 月額約$5 (約750円) | 30,000 (約30分の音声) | 商用利用可 インスタントボイスクローン ダビング | 一部高度な機能なし プロフェッショナルクローンなし | 個人クリエイター 小規模コンテンツ制作 |

| Creator | 月額約$11 (約1,650円) ※初月50%オフ | 100,000 (約100分の音声) | プロフェッショナルボイスクローン 追加クレジット使用量課金 高品質オーディオ(192kbps) | APIの一部機能制限あり | コンテンツクリエイター ポッドキャスト制作 YouTuber |

| Pro | 月額約$99 (約14,850円) | 500,000 (約500分の音声) | APIでの44.1kHz PCMオーディオ 高度な音声調整 優先サポート | – | プロフェッショナル制作 企業利用 アプリ開発 |

| Scale | 月額約$330 (約49,500円) | 2,000,000 (約2,000分の音声) +3シート | マルチシートワークスペース チーム利用機能 高度なAPI機能 | – | スタートアップ 中小企業 出版社 |

| Business | 月額約$1,320 (約198,000円) | 11,000,000 (約11,000分の音声) +5シート | 低遅延TTS 3つのプロフェッショナルボイスクローン 高度な管理機能 | – | 大企業 出版社 メディア企業 |

| Enterprise | 要問合せ | カスタム | DPA/SLAsカスタム条件 HIPAA対応 カスタムSSO 完全管理ダビング | – | 大規模企業 特殊要件のある組織 |

クレジットシステムについて

ElevenLabsでは「クレジット」という単位で使用量を計測します:

- クレジットとは: 音声生成に使用される計算リソースの単位

- 換算目安: 10,000クレジット ≈ 高品質な音声約10分

- 使用量算出: テキストの長さ、選択したモデル、生成設定により変動

- 追加クレジット: Creatorプラン以上では、割安な料金で追加クレジットを購入可能

プラン選択のポイント

私の経験を元に、用途別の最適なプラン選択のアドバイスをします:

- 個人的な実験・学習目的:

- おすすめ: Freeプラン

- 理由: コストをかけずに基本機能を試せる

- 注意点: 商用利用不可、クレジット表記必須

- 個人クリエイター・小規模コンテンツ制作:

- おすすめ: Starterプラン

- 理由: 商用利用可能、基本的なカスタマイズが使える

- 活用例: 月に数回のYouTube動画、個人ブログの音声コンテンツ

- 定期的なコンテンツ制作・ポッドキャスト:

- おすすめ: Creatorプラン

- 理由: プロフェッショナルボイスクローン、高品質オーディオ

- 活用例: 週間ポッドキャスト、YouTubeチャンネル運営、オーディオブック制作

- 企業利用・プロフェッショナル制作:

- おすすめ: Proプラン以上

- 理由: 高度な機能、十分なクレジット量、APIアクセス

- 活用例: 企業マーケティング、e-ラーニングコンテンツ、アプリ開発

私自身は、個人的な実験には無料プランから始め、コンテンツ制作の需要が増えてきたらCreatorプランにアップグレードしました。現在はProプランを利用しており、多言語コンテンツ制作やAPIを使った自動化プロセスを実装しています。

コスト最適化のヒント

- テキストの最適化:

- 不要な繰り返しや冗長な表現を削除する

- 効率的な文章構成で同じ内容をより少ない文字数で表現

- 年間プラン:

- 長期的に使用する予定なら年間プランを選択(2ヶ月分無料になる)

- 効率的なワークフロー:

- 短いセグメントで先にテストし、満足できる結果が得られてから長文を生成

- プリセットを活用して設定時間を節約

- 複数プランの使い分け:

- 実験や小規模プロジェクトには無料アカウント

- 重要な商用プロジェクトには有料プラン

8. 商用利用について:権利と利用規約

ElevenLabsの音声を商用目的で使用する場合は、以下の点に注意が必要です。私も実際にクライアントワークでElevenLabsを利用する際に、これらの規約をしっかり確認しました。

商用利用の条件

- 適切なプランの選択: 商用利用にはStarter($5/月)以上のプランが必要です。無料プランでは商用利用ができず、クレジット表記が必須となります。

- アクセス権と知的財産権:

- 有料プランを契約している場合、生成した音声コンテンツの知的財産権はユーザーに帰属します

- ただし、ElevenLabsのプラットフォームや技術自体の権利はElevenLabsに帰属します

- 音声モデル自体を再配布することはできません

- 禁止されている用途:

- 詐欺や虚偽の情報拡散を目的とした使用

- ヘイトスピーチや差別的内容の生成

- 暴力や犯罪を助長するコンテンツの作成

- 他者の著作権や商標権を侵害する使用

- 政治的な宣伝や選挙への影響を意図した使用

利用規約のポイント

- 知的財産権: 生成された音声の知的財産権は、適切なプランを契約している場合、基本的にユーザーに帰属します

- 音声クローニングの制限: 他者の声をクローニングする場合は、必ず本人の許可を得る必要があります

- コンテンツ制限: ヘイトスピーチ、差別的内容、詐欺的内容などへの使用は禁止されています

商用利用を検討している場合は、最新の利用規約を必ず確認することをおすすめします。規約は更新される可能性があり、特に商用利用に関する条件は変更されることがあります。

9. 類似サービスとの比較

AI音声生成の分野では多くのサービスが登場していますが、それぞれに特徴があります。ここでは、私が実際に使用して比較検討した結果をもとに、ElevenLabsと他の主要サービスを比較します。

主要サービスとの詳細比較

| サービス名 | 強み | 弱み | 料金体系 | 日本語対応 | 使用感 |

|---|---|---|---|---|---|

| ElevenLabs | ・最高レベルの自然な感情表現 ・高度な音声カスタマイズ ・優れた音声クローニング ・直感的なインターフェース | ・比較的高コスト ・無料プランの制限が厳しい ・処理に時間がかかることがある | ・無料:10分/月 ・$5〜$1,320/月 ・使用量に応じた従量課金あり | ○(高品質) | 直感的で使いやすいUI、高品質な音声に感動 |

| Amazon Polly | ・高い安定性と信頼性 ・AWSとの連携が容易 ・低コスト ・高速処理 | ・感情表現が限定的 ・カスタマイズ性に制限 ・独特の「機械っぽさ」が残る | ・100万文字まで無料枠あり ・$4/100万文字(標準) ・$16/100万文字(ニューラル) | ○(標準的) | 安定しているが表現力に欠ける、ビジネスユースに適している |

| Google Cloud TTS | ・多言語対応が充実 ・Googleエコシステムとの連携 ・安定したAPI | ・感情表現が控えめ ・細かいカスタマイズが難しい | ・400万文字/月まで無料 ・$4/100万文字(標準) ・$16/100万文字(WaveNet) | ○(良好) | 多言語対応が優秀、簡潔な文章の読み上げに適している |

| VOICEVOX | ・完全無料 ・キャラクター性が強い ・オフライン使用可能 ・オープンソース | ・商用利用に制限 ・英語など他言語は弱い ・インストールが必要 | ・完全無料 | ◎(特化) | アニメ風の声が特徴的、日本語に特化している |

| VoicePeak | ・日本語特化 ・自然な日本語抑揚 ・買い切り型 | ・国際的な言語対応に制限 ・アップデートに追加費用 | ・買い切り:約15,000円〜 | ◎(特化) | 日本語の自然さはトップクラス、専門用語の発音も優秀 |

各サービスの最適な用途

実際にこれらのサービスを使ってみた経験から、以下のような用途別おすすめができます:

- 感情表現重視のナレーション・創作コンテンツ:

- 最適: ElevenLabs

- 理由: 最も自然で感情豊かな表現が可能

- 実例: 私の物語朗読プロジェクトでは、ElevenLabsの感情表現能力が視聴者の没入感を大幅に向上させました

- 大量のテキスト処理・企業情報システム:

- 最適: Amazon PollyまたはGoogle Cloud TTS

- 理由: 低コスト、高速処理、安定したAPI

- 実例: 顧客向け自動通知システムでは、高速処理が重要なため、Amazon Pollyを選択しました

- 日本語特化の専門的コンテンツ:

- 最適: VoicePeakまたはVOICEVOX

- 理由: 日本語の発音や抑揚が最も自然

- 実例: 医学教材の日本語ナレーションでは、専門用語の発音精度が高いVoicePeakを使用しました

- 多言語展開が必要なプロジェクト:

- 最適: ElevenLabsまたはGoogle Cloud TTS

- 理由: 幅広い言語対応、一貫した品質

- 実例: 多言語マーケティング動画では、ElevenLabsの一貫した音声品質と感情表現が効果的でした

ElevenLabsを選ぶべき理由

私が最終的にElevenLabsを主力ツールとして選んだ理由は以下の通りです:

- 音声の質と感情表現: どのサービスと比較しても、最も人間らしく、感情豊かな音声を生成できます。

- ユーザーフレンドリーなインターフェース: 技術的な知識がなくても、直感的に高品質な音声を作成できます。

- 継続的な改善: 定期的な更新で常に進化し、新機能や改善が追加されています。

- 多機能性: テキスト読み上げだけでなく、会話型AI、吹き替え、音声クローニングなど、多彩な機能を一つのプラットフォームで提供しています。

ただし、予算が限られている場合や大量のテキスト処理が必要な場合は、より低コストのAmazon PollyやGoogle Cloud TTSも検討する価値があります。また、日本語のみのプロジェクトであれば、VOICEVOXやVoicePeakも優れた選択肢となるでしょう。

10. まとめ:ElevenLabsを最大限に活用するためのポイント

この記事では、ElevenLabsの基本から応用まで、私自身の経験を交えながら徹底的に解説してきました。最後に、ElevenLabsを最大限に活用するための重要なポイントをまとめます。

活用のための5つの核心ポイント

- 目的に合った設定の最適化:

- 音声の用途(ナレーション、ストーリーテリング、会話など)に応じて適切な声と設定を選ぶ

- 安定性と明瞭さのバランスを意識し、プレビューを繰り返して最適な値を見つける

- プロジェクトごとに設定プリセットを作成して一貫性を保つ

- 言語ごとの最適化テクニック:

- 日本語コンテンツでは漢字の読み方に注意し、必要に応じてひらがな表記を使用

- 多言語コンテンツでは言語タグを活用して正確な発音を実現

- 各言語に最適な声とパラメータの組み合わせを見つけてメモしておく

- ワークフローの効率化:

- 長文は適切にセグメント分割して処理し、後で結合

- テスト生成→調整→本番生成のサイクルを確立

- APIやバッチ処理で繰り返し作業を自動化(開発知識がある場合)

- コスト最適化戦略:

- 用途に合ったプランを選択(実験には無料プラン、本格的な制作にはCreator以上)

- 年間プランの割引を活用(年払いで2ヶ月分無料)

- テキストの最適化で不要な文字数を削減

- 法的・倫理的配慮:

- 商用利用には適切なプランを契約

- 音声クローニングは必ず同意を得た上で実施

- AI生成音声であることを適切に開示

私のElevenLabs活用体験

ElevenLabsと出会ってから、私のコンテンツ制作ワークフローは劇的に変化しました。以前は音声ナレーションの収録と編集に数時間かけていましたが、今では数分で高品質な音声を生成できるようになりました。

特に印象的だったのは、あるクライアントプロジェクトで10ヶ国語の製品紹介ビデオを作成した時のことです。従来なら各言語のナレーターを雇用し、収録スタジオを手配する必要がありましたが、ElevenLabsを使用することで時間とコストを90%削減しながら、高品質な多言語コンテンツを作成することができました。

また、自分の声をクローニングして使用することで、体調不良や出張中でも一貫した声質のコンテンツを提供できるようになりました。この柔軟性は、特に締め切りの厳しいプロジェクトで大きな価値を生み出しています。

今後の展望

AI音声技術は急速に発展しており、ElevenLabsも継続的に新機能をリリースしています。今後注目すべき発展方向性としては:

- リアルタイム音声生成: より低レイテンシでのリアルタイム対話が可能に

- さらなる多言語対応の拡充: より多くの言語やアクセントのサポート

- 音声編集機能の強化: 生成後の音声を直接編集できる機能

- マルチモーダル統合: 動画生成AIなど他のAI技術との連携

ElevenLabsは自社の研究開発に積極的に投資しており、これらの機能が近い将来実現する可能性が高いです。

最後に

ElevenLabsの世界は奥深く、この記事で紹介した以上の可能性を秘めています。基本を理解し、徐々に応用テクニックを試していくことで、あなたのコンテンツ制作や業務効率化に大きな革新をもたらすことでしょう。

私自身、ElevenLabsを使い始めてから1年以上が経ちますが、今でも新しい使い方や活用法を発見し続けています。ぜひ皆さんも、この記事を参考にElevenLabsの可能性を探求してみてください。きっと、あなたのクリエイティブワークに新たな次元をもたらしてくれるはずです。

何か質問があれば、コメント欄でお気軽にどうぞ。皆さんのElevenLabs活用体験も聞かせていただければ嬉しいです。

更新情報: 本記事は2025年5月時点の最新情報に基づいて作成されています。ElevenLabsの機能や料金プランは変更される可能性がありますので、最新情報は公式サイトでご確認ください。